“バーチャルモデル”はどうやって作られているのか

Miquela、imma、葵プリズム、uca、MEME……CGで作られたインフルエンサー

CGで作られたインフルエンサーを知っていますか?

皆さんは、Instagramに上がっているインフルエンサーの写真を、ファッションやライフスタイルの参考にすることがあるのではないでしょうか。その中に、人間のように見えるけれど、そうではなく、CGで作られたインフルエンサーがいることをご存じですか。

有名なのは、たとえばアメリカのMiquela(ミケーラ)さんや、日本ではimma(イマ)さん、葵プリズムさん、uca(ウカ)さん、MEME(メメ)さんなど。この方たちは「バーチャルモデル」などと呼ばれています。とくにimmaさんは、インスタグラムの中だけでなく、CMに出演したり、TikTokもやっているので、どこかで目にしたことのある人も多いかと思います。

今はまだ、バーチャルモデルの数はそう多くありません。なぜなら、特別な能力をもつクリエーターが、多くの時間や労力をかけて、作っていたからです。

しかし今、「情報処理技術」によって、バーチャルモデルを簡単に作れるようになってきました。その新しい技術によって生まれたのが、この2月に新しく誕生したDripというバーチャルモデルユニットです。

Dripには、紗英(サエ)さん、絵留(エル)さん、梨乃(リノ)さん、蓮(レン)さんという4人のバーチャルモデルがいます。今すでに彼らの静止画がInstagramのDripのアカウントで公開されていますが、今後は動画もTikTokに公開されるそうです。彼らはいったいどのように作られているのでしょうか?

2021年2月に新しく誕生したバーチャルモデルユニット「Drip」

3D-CGで作られてきたバーチャルモデル

3D-CGの仕組み

最初に、これまでのバーチャルモデルがどのように作られてきたか、確認しましょう。CGで作られているということは、皆さんが今よく目にしているアニメやゲームのキャラクターと、基本的には同じです。とくに、バーチャルモデルは立体的に見えると思いますが、最近の映画で例を挙げれば『アナと雪の女王』や『トイ・ストーリー』に出てくるような立体的なキャラクターと、基本的には同じように作られてきました。

では、エルサやウッディがどのように作られているかはご存じでしょうか。順を追って説明しましょう。

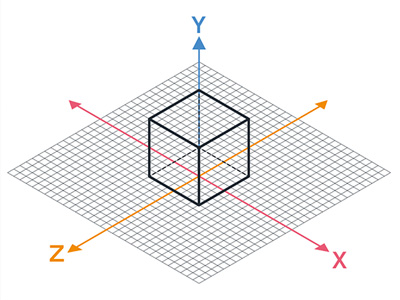

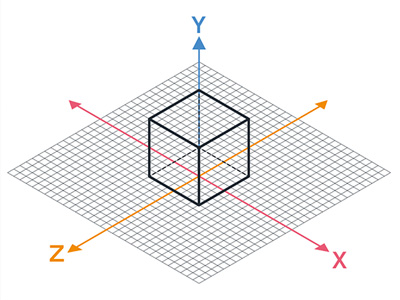

まずはコンピュータ上でキャラクターの立体を1つ作ります。立体を作るというのは次のようなことです。コンピュータの中ではすべて数値化されるので、コンピュータに描く絵も座標によって理解されます。平面的な絵を描くのが「xy座標」上に線や面を描くことであるのに対し、立体を作るというのは「xyz座標」上に線や面を描くことです。このようなコンピュータ上の立体的な絵を「3D-CG」と呼びます。

そうしてできた3D-CGのキャラクターを、少し動かしては、特定の視点から見える絵を記録する、ということを繰り返します。そうしてできた絵を連続させると、キャラクターが動いているように見えるのです。

今、テレビでやっている『PUI PUI モルカー』のようなストップモーション・アニメも、人形を少し動かしてはカメラで撮影する、ということを繰り返し、できた写真を連続させることにより、人形が動いているように見せています。それと同じことをコンピュータの中で行うのです。これが「アニメーション」の原理です。

これまでのバーチャルモデルは、多くの場合、首から下は実際の人間をカメラで撮影した画像を用い、首から上は3D-CGによって作り、合成していました。まるで人間に見えるような顔を3D-CGで作り、まるで人間に見えるような顔の動きをアニメーションで作るのは、イラスト調のキャラクターを作るよりもずっと緻密な作業です。

また、人は、人間の顔に対してとても敏感です。人間の顔のように見えるのに、人間と少しでもずれがあると、人は強い違和感を覚えます。なので、まるで人間に見えるような顔を作るというのは、とても難しい作業なのです。そのため、特別な能力のあるクリエーターが、多くの時間と労力をかけて作ってきました。

人工知能技術で作られる新しいバーチャルモデル

しかし新しく誕生したDripは、新しい情報処理技術を用いて、これまでとまったく異なる方法で作られています。ZOZOテクノロジーズでDripの開発に関わる玉村さんに、詳しいお話をうかがいました。

ZOZOテクノロジーズにおいて、チームリーダーとして3D分野の新規プロジェクトの企画・推進に携わる玉村雄大さん

Dripの画像は、「とても手軽に作ることができます」と玉村さんは言います。これまで多くの時間や労力をかけて作られてきたバーチャルモデルが、なぜ、手軽に作れるようになったのでしょうか。

「Dripの顔は、ディープフェイク(DeepFake)という技術で作成されています。3D-CGで作成した顔の上にディープフェイクによって表情が乗っている、というイメージです。ディープフェイク領域で世界的に有名な企業であるPinscreen社の協力のもと、Dripは生まれました」

たしかに、これまでバーチャルモデルを作るのに、とくに多くの時間や労力を要したのは、顔の詳細な表情などを3D-CGで作る作業でした。その作業がなければ、手軽になるというのは納得します。

では、ディープフェイクとはいったい何でしょうか。またDripは、具体的にどのように作られているのでしょうか。

「実は、Dripのメンバー一人一人には、モデルになっている実在の人がいるのです。実在するモデルの皆さんに協力してもらい、さまざまなライティング環境の下、いろいろな表情や角度で 1日がかりで顔を撮影し、『学習データ』を作りました」

「学習データ」とは何かは、後で確認しましょう。

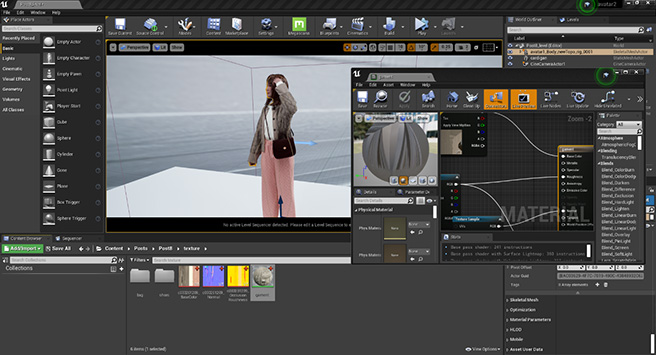

「そしてInstagramやTikTokなどで公開する画像を作るときに、シーンに合わせて髪型や洋服を3D-CGで作ります。このとき顔の部分は、目印だけついているような、ざっくりとした3D-CGを入れてあります」

ここでは髪型や洋服を3D-CGで作っているということですが、実際の人間をカメラで撮影して作ることもできます。ただ、ZOZOテクノロジーズの場合は、バーチャルモデルに、実際に存在しない洋服を実装させることを目的の一つとしているため、3D-CGで作っているようです。

「あとは、3D-CGで作った髪型や洋服の画像を入力すれば、コンピュータが『学習データ』をもとに類推して、それに合った顔を合成して、出力してくれます。レンジでチンするように出してくれるのです。動画でもすぐにできます。その類推をするのが、ディープフェイクという『機械学習』の技術です」

Dripの紗英さん

ディープフェイクの仕組み、わかりましたか?

たとえば、あなたが、ある日、Aさんと初めて会ったとします。学校だったので、Aさんはずっとすました顔をしていました。週末、今度は街で、Aさんとすれ違いました。その時のAさんは笑顔でしたが、表情が違っても、あなたはその人がAさんだとわかると思います。それはあなたがAさんのすました顔をもとに、Aさんの笑顔を類推できるからです。ディープフェイクは、それと同じような類推をできるのです。

このように、人間のような、あるいは人間を超えるような情報処理をする技術を「人工知能」と呼びます。それを実現するための一つのアプローチが「機械学習」。多くのデータを与えるとその特徴を見出し、それをもとに他の特徴も類推できる技術です。最初に多くのデータを与えるほど、類推の精度が高まります。そしてその最初に与えるデータが「学習データ」と呼ばれます。

紗英さんの制作風景

誰もがアバターをもてる時代!?

さきほど、玉村さんは、Dripの一人一人には、モデルになっている実在の人がいると言いました。玉村さんは、その本人とも実際に会っているということで、「顔はまったく同じです」と言います。つまり、そのモデルになっている人は、一日撮影に訪れて、学習データを提供した後は、何もしていないのに、InstagramやTikTokの中で、いろいろな洋服を着たり、いろいろな髪型をしたりして、活動しているのです。

リアル空間の自分とは別に、InstagramやTikTokなどのバーチャル空間の中にもう一人の自分、いわゆる「アバター」をもっているような感覚なのではないでしょうか。もし、この技術が広まれば、私たちも一日撮影に訪ねれば、バーチャル空間にアバターをもてるようになるのでしょうか。

「技術的にはまったく可能です。極端な話、どこかへ撮影に行かなくても、家でスマートフォンのカメラで自撮りをして、アップロードすれば、自分とそっくりのアバターが作れる時代がくるかもしれません」

「VINTAGE MIX」のファッションスタイルを

着て見せるDripの梨乃さん

ZOZOテクノロジーズは、ファッション通販サイト「ZOZOTOWN」の開発を行っています。今後バーチャルモデルが、ZOZOTOWNの上に登場する機会はあるのでしょうか。

「現在はさまざまなファッション分野でのさまざまな活用の可能性を探っている段階です。ただ将来的には、欲しい洋服を自分とまったく同じ体型のバーチャルモデルが着ている姿を見られるようになったらおもしろいのではないか、などということは考えています。

現在は、身長の高いモデルの着用画像が多いため、自分が同じ洋服を着た時を想像しづらいかと思います。そうしたユーザーの課題を解決できると嬉しいですね。とはいえ現状は、手作業で洋服を 3D-CGで作っていて技術的な手間が存在するので、それを効率化・自動化することが目下の課題です」

もしかして、未来は、ZOZOTOWNの中で、誰もが自分と同じ顔のアバターをもてるようになり、ZOZOTOWNで売っている洋服を試着できたりするようになるのでしょうか。

「技術的には可能ですが、お客さんが自分と同じ顔のアバターをもちたいのかどうかは問題です。私たちの目的はあくまでも、お客さんがオンラインで洋服を買うときに困っていることを解決することなので。」

皆さん、自分と同じ顔のアバター、もちたいですか?

記事を書いた人

久保 友香

メディア環境学者

1978年、東京都生まれ。2000年、慶應義塾大学理工学部システムデザイン工学科卒業。2006年、東京大学大学院新領域創成科学研究科博士課程修了。博士(環境学)。専門はメディア環境学。東京大学先端科学技術研究センター特任助教、東京工科大学メディア学部講師、東京大学大学院情報理工学系研究科特任研究員など歴任。日本の視覚文化の工学的な分析や、シンデレラテクノロジーの研究に従事。2008年『3D-CGによる浮世絵構図への変換法』でFIT船井ベストペーパー賞受賞。2015年『シンデレラテクノロジーのための、自撮り画像解析による、女性間視覚コミュニケーションの解明』が総務省による独創的な人向け特別枠「異能(Inno)vation」プログラムに採択。著書に『「盛り」の誕生ー女の子とテクノロジーが生んだ日本の美意識ー』(太田出版、2019年)。